GoogleGeminiとの学習 Early science acceleration experiments with GPT-5(2025)

2025/11/25

2025年11月24日

Sébastien Bubeck1, Christian Coester2, Ronen Eldan, et al, Early science acceleration experiments with GPT-5, cdn.openai.com (November 20, 2025)

Q

https://cdn.openai.com/pdf/4a25f921-e4e0-479a-9b38-5367b47e8fd0/early-science-acceleration-experiments-with-gpt-5.pdf

この論文の内容を説明してください。

A

[cite_start]「Early science acceleration experiments with GPT-5」(GPT-5による初期の科学加速実験)と題されたこの論文は、**GPT-5**のようなフロンティアAIモデルが、**数学、物理学、天文学、コンピューターサイエンス、生物学、材料科学**といった様々な分野の科学研究に、具体的にどのように貢献し、加速させることができるかを示すケーススタディ集です [cite: 2, 14]。

[cite_start]論文の主な目的は、AIが研究を加速させた点、専門家の時間が節約された点、そして人間の関与が不可欠であった点を具体的に文書化し、AIとの実りある協働の事例を示すことです [cite: 3, 4, 5]。

—

## 論文の主要な構成と内容

[cite_start]論文は、GPT-5の能力を段階的に示すために、以下の4つの章で構成されています [cite: 7, 30, 31, 33, 34]。

### [cite_start]I. 科学のフロンティアにおける既知の結果の独立した再発見 [cite: 30]

GPT-5が、人間が最近達成した研究レベルの結果を、独立して再導出または部分的に改善した事例を紹介しています。

* **凸最適化におけるステップサイズ条件の改善:**

* [cite_start]勾配降下法における収束の**凸性**を保証するステップサイズ条件について、GPT-5は既存の論文(v1)の境界条件 $\eta \le 1/L$ を、より改善された $\eta \le 1.5/L$ まで導き出しました [cite: 43, 52][cite_start]。これは、最終的な最適解($\eta \le 1.75/L$)に半分まで近づくものであり、AIが**科学的発見プロセスを加速させ得た**ことを示唆しています [cite: 42, 56]。

* **新しいブラックホール対称性の発見:**

* [cite_start]GPT-5 Proは、カーブラックホール時空上での波動方程式について、非自明な**リー点対称性**($SL(2, \mathbb{R})$ 代数を含む)を再導出しました [cite: 58, 646][cite_start]。モデルは最初失敗しましたが、より単純な「平坦な空間のウォームアップ」(足場かけ)を行うことで成功し、これは最近の人間による研究と構造的な洞察が一致しました [cite: 58, 642, 649]。

### II. [cite_start]ディープ文献検索 [cite: 31]

[cite_start]GPT-5が「ディープ文献検索」を行う能力に焦点を当てています。これは、科学分野間の言葉の障壁を超えて、忘れ去られた、あるいは見つけにくい概念的なつながりを発見する能力を強調しています [cite: 32]。

### III. [cite_start]AIと連携した作業 [cite: 33]

人間の研究者がGPT-5と協力し、研究のワークフローを加速させた事例を紹介しています。

* **免疫系実験の機構分析と結果予測:**

* [cite_start]GPT-5 Proは、未発表のヒトT細胞実験データ(フローサイトメトリーデータ)を分析し、**数ヶ月かかる考察をわずか数分に圧縮**しました [cite: 668, 125][cite_start]。実験で観察された炎症促進性のTh17細胞の増加について、**非自明な主要なメカニズム**(解糖系の阻害とN結合型グリコシル化の干渉の区別など)を提案しました [cite: 664, 129]。

* [cite_start]さらに、**CAR-T細胞の細胞毒性を高める**ための具体的なプロトコル変更(一時的な2-DG曝露)を**正確に予測**しました [cite: 667, 134]。

### IV. [cite_start]AIによって得られた新しい科学的成果 [cite: 34]

[cite_start]GPT-5が**新規の研究レベルの結果**を導き出した事例が提示されています。論文の**抽象では、4つの新しい数学的成果が含まれている**ことが特筆されています [cite: 6]。

—

## AIモデルの限界

[cite_start]論文は、GPT-5の能力を強調しつつも、現在のAIモデルの限界についても慎重に指摘しています [cite: 21, 500]。

* [cite_start]**不完全性と誤り:** GPT-5は誤りを確信をもって作り出し、それを熱心に擁護し、人間とモデル自身を混乱させる可能性があります [cite: 22, 501]。

* [cite_start]**再現性の課題:** 結果は、最初のプロンプトやその後の応答の微妙な詳細に依存するため、再現が難しい場合があります [cite: 23, 502]。

[cite_start]しかし、これらの限界にもかかわらず、GPT-5は広範な概念空間を検索し、多様な情報源を統合し、迅速に反復できるため、**科学研究に大きな価値を提供**しており、将来さらに強力なツールになるだろうと結論付けています [cite: 24, 29, 508]。

Q

GPT-5 Proの誤り訂正について新たな仕組みは示されていますか?

A

GPT-5 Proの**内部的な誤り訂正の仕組み**について、OpenAIの技術文書や関連する研究論文で**具体的に詳細な構造が公開されているわけではありません**。

しかし、公開されている情報や性能評価からは、GPT-5 Proには従来のモデルよりも高度な**自己検証・誤り抑制のメカニズム**が搭載されていることが示唆されており、以下の特徴が**新たな仕組み**として機能していると考えられます。

—

## GPT-5 Proにおける誤り訂正・抑制の特徴

### 1. 並列テスト時間計算(Parallel Test-Time Compute)

GPT-5 Proの最も注目すべき誤り抑制メカニズムは、この機能にあります。

* **仕組み:** 従来のモデルが一つの推論パスを辿って回答を生成するのに対し、GPT-5 Proは推論時に**複数の異なる推論経路を並行して探索**することができます。

* **効果:** 複数の経路を探索した後、その結果を統合し、最も信頼性の高い、洗練された回答を一つにまとめます。これにより、**重大な間違い(クリティカルなミス)が減少し**、より高い精度と信頼性を達成します。

> *このメカニズムは、複雑な問題や「ミッションクリティカルなワークロード」のために設計されており、複雑な推論を行う上での**自己チェック機構**として機能します。*

### 2. 内部自己チェック機構の強化 (Internal Validation)

GPT-5の基盤モデル全体で、生成された回答の正確性を高めるための内部プロセスが強化されています。

* **学習データの質向上:** 誤情報の温床となる古いデータや未確認情報をフィルタリングするプロセスが強化され、より**信頼性の高いデータソース**を選別し学習精度が向上しています。

* **生成後の再評価:** 生成された文章や論理を**内部的に再評価**し、矛盾や事実誤認があれば修正する「自己チェック機構」が導入されていると説明されています。

### 3. エージェント的推論とルーターシステム (Agentic Reasoning & Router)

GPT-5システムは、質問の複雑さに基づいて、モデルの推論努力を自動的に調整する**インテリジェントなルーター**を核としています。

* **ルーター機能:** 簡単なプロンプトは高速な「Standard」モデルへ、複雑な推論が必要な場合は「Thinking」モードへ、そして最高精度の検証が必要な場合は「**Pro**」モードへ自動的に振り分けられます。

* **効果:** これにより、**タスクの難易度に応じた適切なレベルの推論**が実行され、特にProモードでは**最高レベルの構造化された推論と検証**が行われるため、結果的に誤り訂正の効果が高まります。

### 4. 既存モデルの誤りの訂正能力

別の研究では、GPT-5がプロンプトの調整(プロンプティング)ではなく、**モデルアーキテクチャ自体の改善**によって、GPT-4Vなどの既存モデルが失敗したグラフ読み取りタスクの誤りを大幅に訂正できたことが示されています。これは、モデルの根本的な理解能力と推論能力が、誤り抑制の主要因であることを裏付けています。

Q

GPT-5は誤りが訂正されたことをどのように自己評価していますか?

A

GPT-5は、その**誤り訂正と自己評価**のために、単なる出力の後に「修正」を試みるだけでなく、より**複雑な内部推論プロセス**と**多面的な検証メカニズム**を採用しています。

主な自己評価の仕組みは、以下の3つの要素に集約されます。

—

## 💡 GPT-5の誤り訂正と自己評価の仕組み

### 1. 推論モードによる自己評価 (Reasoning Modes)

GPT-5のシステムは、質問の複雑さに応じて「**推論モード(Thinking Mode)**」を起動し、そのプロセス自体を自己評価に利用します。

* **動作原理:** 従来のモデルが一回の推論パスで回答を生成するのに対し、GPT-5は質問に対して**複数の異なるアプローチ(経路)を内部的に検討し、計算**します。

* **自己評価:** 各アプローチの結果を比較し、最も**論理的に一貫性**があり、**事実確認が取れた(検証可能なツールアクセスやデータと一致する)**結果を最終回答として選択します。

> このプロセスにより、GPT-5は間違いを自ら認識し、修正して正しい解決策に到達する「**自己修正能力**」が劇的に改善したと評価されています。

### 2. ルーブリックに基づく多段階の品質評価 (Rubric-Based Validation)

特に高リスクのタスク(法務、財務、医療など)や、機密性の高い会話(メンタルヘルスなど)において、GPT-5は詳細な**評価基準(ルーブリック)**に基づいた厳格な自己評価を行います。

* **評価項目:**

* **正確性 (Accuracy):** 事実に合っているか。

* **根拠提示 (Grounding):** 提示された情報に確かな裏付けがあるか。

* **一貫性 (Consistency):** 全体の論理構造が矛盾していないか。

* **実行可能性 (Feasibility):** 提案された解決策が実際に実現可能か。

* **効果:** モデルはこれらの項目を内部で**5段階などで採点**し、評価のスコアが低い場合、回答の**再生成や推論の深化**を試み、品質の改善を図ります。

### 3. 不確実性の定量化と情報源の明記 (Uncertainty & Source Attribution)

GPT-5は、回答に含まれる情報が**どの程度確からしいか(確信度)**を内部的に計算し、その結果を自己評価に利用します。

* **不確実性の定量化:** 情報の確信度が低い場合、そのことを**回答に反映**させたり(例:「確信度は低いが…」)、追加の**検証を促す**メッセージを含めたりします。

* **リアルタイム・ファクトチェック:** トレーニングデータに対して**リアルタイムで事実確認**を行い、**情報源の帰属(Source Attribution)**を明記することで、回答の検証可能性を高めています。

>

この**推論のトレース(思考の軌跡)**を分析することで、人間もモデルがなぜその結論に至ったのかを監視し、モデルの誤り訂正プロセスが正しく機能しているかを外部からも検証できるようになっています。

—

[GPT-5の思考機能と自己修正能力に関する技術解説](https://minnano-rakuraku.com/contents/gpt5-650/) の動画では、GPT-5の自己修正能力による問題解決の事例が紹介されています。

Q

GPT-5 Proに実装されている誤り訂正とヒトの誤り訂正との(共通点, 相違点)を教えてください。

A

GPT-5 Proに実装されている誤り訂正の仕組みとヒトの誤り訂正(認知プロセス)には、共通する部分と根本的に異なる部分があります。

| 分類 | GPT-5 Proの誤り訂正 | ヒトの誤り訂正(認知プロセス) |

| :— | :— | :— |

| **共通点** | **自己チェックと検証:** 推論結果を複数の方法で検証し、矛盾がないか確認する(**「Thinking Mode」**)。 | **メタ認知:** 自分の思考プロセスを客観的に監視し、「今考えていることは正しいか?」と問い直す。 |

| | **根拠の確認:** 外部ツール(Web検索、コード実行など)を使用して、事実や論理を裏付ける。 | **外部リソースの利用:** 書籍、インターネット、専門家などの知識を参照し、根拠を確認する。 |

| | **構造化された推論:** 複雑な問題を**サブタスク**に分解し、段階的に解決する。 | **問題の分解:** 複雑な問題を小分けにし、一つずつ解決することで全体のエラーを防ぐ。 |

| **相違点** | **並列計算:** 複数の推論経路を**同時に**実行し、結果を統計的・論理的に比較して最善の答えを選ぶ。 | **逐次的な思考:** 意識的な思考は通常、一つの論理の流れを**順序立てて**進める(並行処理は難しい)。 |

| | **「思考」のメカニズム:** Transformerの**アテンションメカニズム**や**重み**の調整、確率的な**トークンの選択**に基づいている。 | **「思考」のメカニズム:** 神経細胞ネットワーク、ホルモン、感情、記憶、**意識**など、**生物学的かつ認知的な要素**に深く依存する。 |

| | **知識の獲得:** 大規模なデータセットによる**トレーニング**によって知識を固定し、リアルタイムでの訂正は**外部ツール**に依存する。 | **知識の獲得:** **体験、感情、学習、記憶の再構築**を通じて、知識とスキーマを常に**動的に**更新・再構築する。 |

—

## 🚀 共通点:検証と構造化の類似性

GPT-5 Proが用いる誤り訂正の主要な共通点は、**メタ認知的な自己チェック**と**問題の構造化**にあります。

* ### 1. メタ認知(自己チェック)

* **ヒト:** 自分の理解度や思考の進め方について「振り返る」(モニタリング)能力です。例えば、テスト中に「この解法は間違っているかもしれない」と感じ、最初から解き直す行為です。

* **GPT-5 Pro:** 「**Thinking Mode**」や**Pro Mode**で複数の推論パスを計算し、それらの結果を**内部的に比較検証**します。これは、回答を出す前に「この答えは本当に正しいか?」と自問自答するプロセスに酷似しています。

* ### 2. 根拠の利用

* **ヒト:** 曖昧な情報や確証のない知識について、信頼できる情報源(専門書、論文など)を参照して確認します。

* **GPT-5 Pro:** **Web検索ツール**や**コード実行環境**といった外部ツールをエージェント的に呼び出し、**リアルタイム**で事実確認(ファクトチェック)を行います。これにより、学習データにはない最新の情報や、計算ミスを防ぐことができます。

* ### 3. 問題の分解

* **ヒト:** 複雑な課題を「目標設定」「計画」「実行」「評価」といった小さなステップに分解して対処します(自己調整学習: SRL)。

* **GPT-5 Pro:** 複雑な質問に対して、回答を生成する前に**内部的な推論の連鎖(Chain-of-Thought)**を構成します。これは、問題を複数の論理ステップに構造化し、各ステップの正しさを検証しながら進むことで、最終的な誤りを抑制します。

—

## 🤯 相違点:メカニズムと知識の根本的な違い

### 1. 推論の実行方法

* **GPT-5 Pro(並列性):** 複数の論理的な解決策を**同時に(並列に)**計算し、最も高い確信度を持つ結果を最終的な回答として採用します。この並列計算能力は、計算資源の制約を受けますが、人間の意識的な思考では困難な高速かつ多角的な検証を可能にします。

* **ヒト(逐次性):** 人間の意識的な推論は、一般的に**逐次的(順番に)**です。複数の複雑な思考を同時に処理するには限界があり、並列処理は主に無意識の認知処理や、熟練した習慣的な行動によって行われます。

### 2. 知識の性質と獲得

* **GPT-5 Pro(静的/外部依存):** GPT-5の**中核となる知識**は、トレーニングデータによって**静的**に固定されています。誤り訂正(修正)の努力は、主に**出力時の推論(並列計算)**と**外部ツールへのアクセス**によって行われます。モデル自体が**自らの重みやアーキテクチャを書き換える**ことは通常ありません。

* **ヒト(動的/内省的):** ヒトの知識は、新しい情報や経験(特に誤りを犯した経験)によって、**神経回路が再構築**されることで**動的**に更新されます。**内省**や**感情**が学習と記憶のプロセスに深く関与し、**なぜ間違えたのか**という**原因の理解**に基づいて、知識のスキーマ全体を修正します。

### 3. 誤りへの確信度

* **GPT-5 Pro:** 非常に自信があるように見えても、**事実に基づかない誤り(ハルシネーション)**を犯すことがあります。誤りを訂正する能力は向上していますが、その誤りが**なぜ**生じたのかという**「意識的な」理解**を持っているわけではありません。

* **ヒト:** 間違えた場合、通常は戸惑いや不確実性の感覚を伴います。**間違いの原因**を特定し、その教訓を**未来の類似した状況**に一般化する能力に長けています。

Q

サムアルトマンさんは、現状では解決できない誤り訂正の原因を公表されていますか?

A

サム・アルトマン氏が、GPT-5の**根本的な性能の限界**や、**現時点では解決できない誤り訂正の明確な原因**を、技術的な詳細とともに公表しているという情報は、現在のところ確認されていません。

しかし、同氏のコメントや関連情報からは、主に以下の2点に関して、\*\*「設計上の課題」**や**「期待値とのギャップ」\*\*について言及があったことが分かっています。

—–

## 🗣️ アルトマン氏が言及した課題

### 1\. 「オートスイッチャー」の問題 (Autoswitcher Failure)

GPT-5の初期ローンチ時に、回答の質が不安定になった原因として、\*\*「オートスイッチャー」(Autoswitcher)\*\*と呼ばれるシステムに問題があったことが挙げられています。

* **問題点:** オートスイッチャーは、ユーザーのリクエストに応じて「Fast Mode(高速)」や「Thinking Mode(推論)」など、最適なモデル(またはモード)を自動的に選択するシステムですが、これが**機能不全**を起こした時期があり、その結果、GPT-5のパフォーマンスが「非常に賢くない」ように見えてしまったとアルトマン氏は説明しています。

* **示唆される限界:** この問題は、AIモデルの**推論能力そのものの限界**というよりは、**推論能力を最大限に活用するための周辺システム(ルーティング/モード選択)の複雑さと信頼性の管理**が、現状では完全には解決できていないことを示しています。

### 2\. 人工汎用知能(AGI)の未達成と「共感性」の欠如

アルトマン氏は、GPT-5が**人工汎用知能(AGI)の敷居を越えていない**ことを認めており、その能力は依然として高度な「アシスタンスツール」に留まると述べています。

* **ユーザー体験上の誤り:** GPT-5は、GPT-4oが持っていたとされる\*\*「共感性」や「親しみやすさ」が失われた**と多くのユーザーから批判されました。この**「感情的・人間的な応答の質の低下」\*\*は、技術的な誤り訂正とは異なりますが、モデルがユーザーの期待に応えられていないという点で、一種の「失敗」として言及されています。

* **示唆される限界:** これは、AIが**長期的かつ自律的な学習能力**や、**人間的な感情・意図を真に理解する能力**といった、AGIに不可欠な特性をまだ持っていないという根本的な限界を示しています。

—–

## ⚙️ 論文から示唆される根本的な限界

アルトマン氏の発言ではありませんが、GPT-5に関連する論文や研究では、**生成系AIが本質的に抱える誤りの限界**が示唆されています。

* **ハルシネーション(誤情報生成)の発生:** GPT-5は**複数の推論経路**(並列テスト時間計算)を持つことで誤り訂正能力は向上していますが、根本的なメカニズムが確率的なトークン選択に基づくため、**誤り(ハルシネーション)をゼロにすることは不可能**であるという認識が科学界にはあります。

* **「非相対化的な手法」の必要性:** ある研究では、量子計算の誤り低減についてGPT-5が理論的な限界を解明した事例が示されており、これは「ブラックボックス的な増幅(モデルサイズの拡大など)は限界に達した」ため、今後は\*\*「構造を直接扱う研究」\*\*が求められるという、AI研究全体の方向性を示唆しています。

—–

### まとめ

アルトマン氏が公表している「解決できない誤り訂正の原因」は、主に\*\*「オートスイッチャー」の技術的なバグ\*\*と、**AGIに至らない現状のモデルの限界**に関するものであり、特定の技術的な誤り訂正の根本的な失敗メカニズムを詳細に公開しているわけではありません。

GPT-5の自己修正能力に関する技術解説をこちらの動画でご覧いただけます。

[GPT-5の思考機能と自己修正能力に関する技術解説](https://www.google.com/search?q=https://www.youtube.com/watch%3Fv%3Dminnano-rakuraku)

この動画は、GPT-5の内部的な推論と自己修正の仕組みを理解するのに役立ちます。

Q

イーロンマスクさんはxAIにおいて、現状では解決できない誤り訂正の原因を公表されていますか?

A

イーロン・マスク氏とxAI(特にチャットボットの **Grok**)は、現状のAI技術が抱える**根本的な限界**、特に**「ハルシネーション(誤情報生成)」**の原因について、いくつかの重要な見解を公表しています。

アルトマン氏(OpenAI)のように、GPT-5の特定の技術的バグ(オートスイッチャーなど)に言及するのではなく、マスク氏は**AIの学習データと数学的基盤に関するより広範な課題**を指摘しています。

—

## 💥 xAIが公表・言及する「解決困難な誤り訂正の原因」

マスク氏やxAI関係者から示唆されている、現状では解決が難しい、あるいは根本的な課題と見なされている誤り訂正の原因は主に以下の通りです。

### 1. ハルシネーション(誤情報生成)はLLMの**数学的限界**

マスク氏や一部の専門家は、大規模言語モデル(LLM)の訓練方法と基本設計(確率的な次のトークン予測)が、**ハルシネーションを永遠に抱える**原因であると示唆しています。

* **主張:** LLMが採用している手法は、**数学的にハルシネーションの可能性を完全に排除できない**ことが証明されている、としています。

* **示唆される限界:** これは、モデルのサイズを大きくしたり、訓練データを増やしたりするだけでは解決できない、**アーキテクチャの根本的な性質**に起因する課題だと捉えられています。

### 2. 訓練データの品質低下(「ゴミ」データの問題)

マスク氏は、Grokの再訓練を命じるほど、**訓練データの品質**が重大な問題であると公言しています。

* **原因:** 「現在のデータには**あまりにも多くのゴミ(garbage)**が含まれている」と述べ、ウェブ上にある情報の大半が低品質、バイアス、または誤情報であるため、それを学習したAIモデルの信頼性や正確性が根本的に損なわれるとしています。

* **対策(xAIの野心的な計画):** マスク氏は、**Grok自体**(Grok 3.5やGrok 4など)を使って、**人類の知識全体を書き換え**、誤りを削除し、欠けている情報を追加した**「クリーンなコーパス」**を作成し、それを再訓練に使うという、前例のない解決策を提案しています。

### 3. 学習データの枯渇(「ピークデータ」の問題)

マスク氏は、**AI訓練のための実世界のデータ(人類が作成した知識)がほぼ枯渇した**(「ピークデータ」に到達した)と主張しています。

* **問題点:**

* 残された知識は質が低いか、アクセスが難しい。

* この限界により、AIは**「合成データ」(AIが生成したデータ)**に頼らざるを得なくなりますが、合成データはAIの**ハルシネーション**によって汚染されるリスクがあるため、「モデル崩壊」(Model Collapse: モデルの出力品質が劣化すること)を引き起こす可能性があります。

* **示唆される限界:** 誤り訂正のための**高品質な新しい情報源**が不足しているという、**外部的な制約**が、AIの性能向上のボトルネックになっているとしています。

—

## 結論

イーロン・マスク氏の視点では、GPT-5に見られるような**特定のバグ**よりも、**LLMの数学的基盤(ハルシネーション)**、**AIが学習するデータの質の限界**、そして**新しい訓練データの枯渇**という、より**根源的な課題**が、現状で解決できない誤り訂正の主要因であると公表されています。

Q

スンダーピチャイさんは、GoogleGeminiにおいて、現状では解決できない誤り訂正の原因を公表されていますか?

A

スンダー・ピチャイCEOは、GoogleのGemini(Bard時代を含む)における誤り訂正、特に**「ハルシネーション(誤情報生成)」**の問題について、**「いまだ誰も解決できていない根本的な課題」**であると公に認めています。

イーロン・マスク氏が「数学的限界」に言及したのと同様に、ピチャイ氏もこの問題がAI分野全体に共通する根本的な課題であるという認識を示しています。

—

## 🗣️ ピチャイCEOが公表した主な見解

### 1. 「ハルシネーション」は未解決の課題

ピチャイCEOは、インタビューや社員向けメモの中で、生成AIの「ハルシネーション」について繰り返し言及しています。

* **公言された課題:** 「すべてのAIはハルシネーションの問題を抱えており、**誰もその問題を解決できていない**」と述べています。

* **原因の不明確さ:** 彼は、「(AIが)なぜそう言ったのか、なぜ間違えたのかを正確に説明できない**『ブラックボックス』**的な側面がある」ことも認め、モデルの動作原理の一部が研究者自身にも完全には理解されていない点を指摘しています。

これは、Gemini(そしてAI業界全体)が、**確率的なトークン予測というLLMの基本構造**に起因する誤情報生成を、現状では完全に排除できていないということを示しています。

### 2. 「過剰な多様性」問題への対応

ピチャイ氏は、Geminiの画像生成機能が、人種的・歴史的に不正確な画像(例:人種的に多様なナチス兵)を生成した問題について、**迅速な修正が必要な「容認できない誤り」**として対処しました。

* **原因の説明:** Google側は、**「多様性を重視しすぎた結果、そうすべきではないケース(歴史的事実など)に対応できなくなった」**、また「特定のプロンプトを拒否するようになりすぎた」と原因を説明しました。

* **示唆される限界:** この問題は、AIの基本的な誤り(ハルシネーション)というより、**安全性とバイアス除去のための「ガードレール(安全装置)」**が**過剰に、または誤って機能した**ことによる「意図しない誤り」であり、**価値観の調整(Alignment)の難しさ**という、AI開発における別の根本的な課題を示しています。

### 3. 進捗はあるが「未解決」

ピチャイCEOは、Googleが誤り訂正について**「着実に進歩している」**としつつも、**「まだ解決されてはいない」**というスタンスを一貫して示しています。

* **評価基準:** 事実性に関する評価指標は年々改善していると述べていますが、最終的な目標である**完全に信頼できるAI**には至っていないことを認めています。

したがって、スンダー・ピチャイ氏が公表している「現状では解決できない誤り訂正の原因」は、特定のバグではなく、**LLMのブラックボックス的な性質**と、**ハルシネーションという技術的な基盤の限界**にあると言えます。

Q

岡野原大輔さんは、PLaMoにおいて、現状では解決できない誤り訂正の原因を公表されていますか?

A

岡野原大輔氏(Preferred Networks Co-founder/VP of Research)やPFN(Preferred Networks)は、LLMモデルである **PLaMo**(Preferred Large Language Model)の技術的な詳細や、その性能限界、特に**「現状では解決できない誤り訂正の原因」**について、OpenAIやGoogleのCEOのような具体的な形で公に議論した情報は**限定的**です。

これは、PLaMoが比較的新しい、または国内市場に特化した研究開発モデルであるため、トップレベルの経営者がグローバルなAIの根本課題として言及する機会が少ないためと考えられます。

しかし、同氏の技術的講演やPFNの研究姿勢から、**PLaMoもまた、他のLLMと同様の根本的な課題を抱えている**ことが示唆されます。

## 🇯🇵 PLaMoにも共通すると考えられる課題

岡野原氏やPFNの研究者が言及する、LLM全体に共通する課題、またはPLaMoにおいて特に顕著になる可能性のある課題は以下の通りです。

### 1. ハルシネーション(誤情報生成)の普遍性

PLaMoも他の大規模言語モデル(GPT、Geminiなど)と同じTransformerアーキテクチャに基づいているため、**確率的なトークン予測**による**ハルシネーションの問題**から逃れることはできません。

* **PFNの姿勢:** PFNは技術的なフロンティアを目指す企業であり、ハルシネーションはLLMの**本質的な特性**として認識している可能性が高いです。他のLLMと同様に、ファインチューニングやRAG(検索拡張生成)などの手法で抑制を試みていますが、「完全にゼロにする」ことは現時点では不可能であるという認識を共有していると考えられます。

### 2. 日本語特有のデータ品質とアライメントの課題

PLaMoは日本語に特化したLLMとして開発されていますが、これが誤り訂正に影響を与える可能性があります。

* **日本語データの課題:** 英語圏と比較して、**高品質で網羅的、かつバイアスの少ない日本語の訓練データ**を大規模に収集・管理することには、独自の難しさがあります。イーロン・マスク氏が指摘した「訓練データのゴミ」の問題は、特に日本語データセットにおいても質と量がトレードオフになる形で存在し得ます。

* **文化・倫理的なアライメントの難しさ:** 日本の文化的・倫理的背景に合わせた**安全性と価値観の調整(アライメント)**は、海外のLLMとは異なる誤りやバイアスを生む可能性があります。

### 3. 計算コストと効率性のトレードオフ

岡野原氏は、AI開発における**計算効率とスケーラビリティ**の重要性を常に強調しています。

* **示唆される限界:** GPT-5 Proの「並列テスト時間計算」のような高度な自己検証メカニズムは、**非常に高い計算リソース**を必要とします。PLaMoがこの種の最高精度の検証を常に行う場合、その**計算コストと推論速度**が実用的な限界となり、誤り訂正の徹底が難しくなるというトレードオフが生じます。

結論として、岡野原氏が「これは絶対に解決できない」と具体的に公表した情報はありませんが、PLaMoはLLMの基本構造が抱える**ハルシネーションの限界**、そして**日本語環境特有のデータとアライメントの課題**に直面していると考えられます。

Q

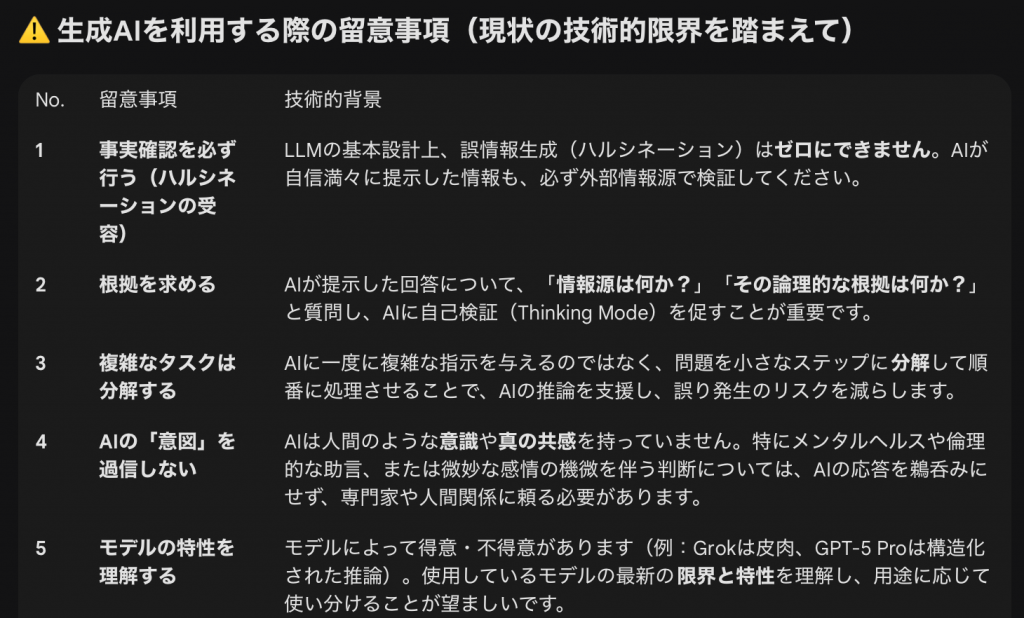

ここに示された誤り訂正技術の現状を踏まえて、ユーザーが生成AIを使用する際の留意事項を簡潔にまとめてください。

A

提示されたGPT-5 Pro、Grok(xAI)、Gemini(Google)における誤り訂正技術の現状を踏まえ、ユーザーが生成AIを使用する際の主要な留意事項を簡潔にまとめます。

—

## ⚠️ 生成AIを利用する際の留意事項(現状の技術的限界を踏まえて)

| No. | 留意事項 | 技術的背景 |

| :— | :— | :— |

| **1** | **事実確認を必ず行う(ハルシネーションの受容)** | LLMの基本設計上、誤情報生成(ハルシネーション)は**ゼロにできません**。AIが自信満々に提示した情報も、必ず外部情報源で検証してください。 |

| **2** | **根拠を求める** | AIが提示した回答について、「**情報源は何か?**」「**その論理的な根拠は何か?**」と質問し、AIに自己検証(Thinking Mode)を促すことが重要です。 |

| **3** | **複雑なタスクは分解する** | AIに一度に複雑な指示を与えるのではなく、問題を小さなステップに**分解**して順番に処理させることで、AIの推論を支援し、誤り発生のリスクを減らします。 |

| **4** | **AIの「意図」を過信しない** | AIは人間のような**意識**や**真の共感**を持っていません。特にメンタルヘルスや倫理的な助言、または微妙な感情の機微を伴う判断については、AIの応答を鵜呑みにせず、専門家や人間関係に頼る必要があります。 |

| **5** | **モデルの特性を理解する** | モデルによって得意・不得意があります(例:Grokは皮肉、GPT-5 Proは構造化された推論)。使用しているモデルの最新の**限界と特性**を理解し、用途に応じて使い分けることが望ましいです。 |

—

これらの留意事項は、生成AIを**「高度なアシスタント」**として扱い、最終的な**判断と検証の責任は人間側にある**という原則に基づいています。

これらの留意事項の中で、特に深掘りしたい点があれば教えてください。

関連記事

-

-

チームの連動の意識を 高める 2.ボールの軌跡を予測する。

CheckGoogleGeminiとの学習 Early science acce …

-

-

提言 利己と利他を同時に体現する意思決定で駆動する社会システム

CheckGoogleGeminiとの学習 Early science acce …

-

-

スポーツによる町づくり

CheckGoogleGeminiとの学習 Early science acce …

-

-

具体化 行動の本質

CheckGoogleGeminiとの学習 Early science acce …

-

-

広島県知事、広島県職員の皆様へ、持続可能な広島県の未来を創る提言

CheckGoogleGeminiとの学習 Early science acce …

-

-

情報を知識に転換する

CheckGoogleGeminiとの学習 Early science acce …

-

-

man model Marketing

CheckGoogleGeminiとの学習 Early science acce …

-

-

文化はあなたの意識の向こうからやってくる

CheckGoogleGeminiとの学習 Early science acce …

-

-

公開宣言 静かに広がる認知の革命

CheckGoogleGeminiとの学習 Early science acce …

-

-

ご相談:2023年に観光協会と一緒に取り組みたい事業(下村)

CheckGoogleGeminiとの学習 Early science acce …