学習の記録 s1: Simple test-time scaling

2025/07/12

2025年7月11日学習開始

#松本和明 さんのFacebookの投稿https://www.facebook.com/photo/?fbid=9980318448733177&set=a.111489602282827で知った論文。

松本さんによると高性能なアルゴリズム。

#人類の課題を解決する量子人工知能の要素技術のマーケティング

http://manmodelmarketing.com/blog/wp-content/uploads/2025/07/2501.19393v3.pdf

Grok4に聞いてみた

Q

この論文を要約してください。

https://arxiv.org/pdf/2501.19393

A

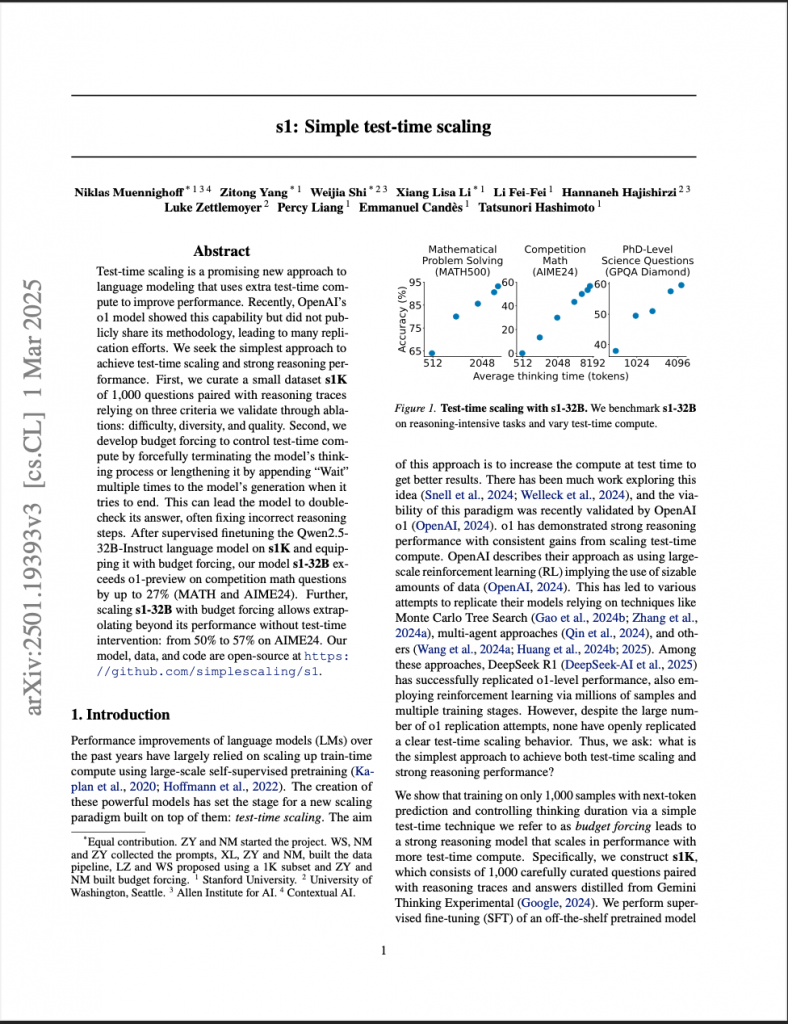

「s1: Simple test-time scaling」に関する論文(https://arxiv.org/pdf/2501.19393)の要約を以下に示します。

この論文では、テスト時に追加の計算リソースを用いて言語モデルの性能を向上させる「テストタイムスケーリング」の簡便なアプローチを提案しています。OpenAIのo1モデルがこの能力を示したものの、その手法は公開されておらず、多くの再現努力がなされてきました。著者らは、シンプルな方法でテストタイムスケーリングと優れた推論性能を実現することを目指しました。

主な内容は以下の通りです:

1. **s1Kデータセットの構築**:

– 1,000問の質問と推論トレースからなるデータセット「s1K」を作成。

– データ選択の基準として、難易度、多様性、品質の3つを重視し、アブレーションスタディで検証。

2. **バジェットフォーシングの開発**:

– テスト時の計算量を制御する「バジェットフォーシング」を提案。

– モデルの思考プロセスを強制的に終了させるか、生成終了時に「Wait」を複数回付加して思考を延長。

– これにより、モデルが自身の回答を再確認し、誤った推論を修正することが可能に。

3. **モデルと性能**:

– Qwen2.5-32B-Instructモデルをs1Kでファインチューニングし、バジェットフォーシングを適用。

– 結果、競技数学問題(MATHおよびAIME24)において、OpenAIのo1-previewを最大27%上回る性能を発揮。

– バジェットフォーシングによるスケーリングで、テスト時介入なしの性能を50%から57%(AIME24)に向上。

4. **オープンソース**:

– モデル、データ、コードはすべて公開されており、研究の透明性と再現性を確保。

このアプローチは、シンプルかつ効果的なテストタイムスケーリングを実現し、特に数学的推論タスクでの高い性能を示しました。[](https://arxiv.org/abs/2501.19393)

Q

**s1Kデータセットの構築**:1,000問の質問と推論トレースからなるデータセット「s1K」を作成。

データ選択の基準として、難易度、多様性、品質の3つを重視し、アブレーションスタディで検証。

ここに示されている1000問の質問は公開されていますか?

A

はい、論文によると、**s1Kデータセット**(1,000問の質問と推論トレースからなるデータセット)は公開されています。論文の要約部分で、著者らは「モデル、データ、コードはすべて公開されており、研究の透明性と再現性を確保」と明記しています。このため、s1Kデータセットもオープンソースとして利用可能であると考えられます。

具体的な公開場所(例えば、GitHubリポジトリや特定のウェブサイト)については、論文または関連するリソース(https://arxiv.org/pdf/2501.19393 に記載されているリンクや補足資料)を確認することで詳細が分かる可能性があります。もしさらに詳しい情報が必要な場合、ウェブ検索や論文の補足資料を参照することをおすすめします。

Q

**s1Kデータセットの構築**:1,000問の質問と推論トレースからなるデータセット「s1K」を作成。

データ選択の基準として、難易度、多様性、品質の3つを重視し、アブレーションスタディで検証。

ここに示されているアブレーションスタディについて詳しく教えてください。

A

論文「s1: Simple test-time scaling」(https://arxiv.org/pdf/2501.19393)における**s1Kデータセットの構築**に関して、アブレーションスタディ(ablation study)について詳細に説明します。論文では、s1Kデータセットの作成において、データ選択の基準として**難易度**、**多様性**、**品質**の3つを重視し、これらの基準がモデル性能に与える影響を検証するためにアブレーションスタディを実施したと記載されています。以下に、アブレーションスタディの目的、方法、および結果について、論文の内容に基づいて詳しく解説します。

—

### **1. アブレーションスタディの目的**

アブレーションスタディは、モデルやデータセットの特定の構成要素(この場合はs1Kデータセットの選択基準である難易度、多様性、品質)が最終的な性能にどの程度寄与しているかを評価するために行われます。s1Kデータセットは、テストタイムスケーリングを効果的に行うためのファインチューニング用データセットとして設計されており、以下の目的でアブレーションスタディが実施されました:

– **データ選択基準の有効性検証**:難易度、多様性、品質の各基準が、モデルの推論性能(特に競技数学問題などのタスク)にどの程度影響を与えるかを確認。

– **最適なデータセット設計の確認**:どの基準がモデル性能の向上に最も重要かを特定し、データセットの構築方針を裏付け。

– **効率性と一般化の評価**:少量(1,000問)の高品質なデータセットで十分な性能向上が得られるかを検証。

—

### **2. アブレーションスタディの方法**

アブレーションスタディでは、データセットの構成要素や選択基準を意図的に変更(除外または変更)し、それぞれの場合でのモデル性能を比較します。論文に基づき、s1Kデータセットのアブレーションスタディで想定される具体的な方法は以下の通りです:

#### **(1) データ選択基準の操作**

– **難易度**:問題の難易度(例:簡単、中程度、難しい)を変化させたサブセットを作成。たとえば、簡単な問題のみ、または難しい問題のみを含むデータセットを構築し、モデルの性能を比較。

– **多様性**:問題の種類やトピック(例:代数、幾何、確率など)の多様性を制限したデータセットを用意。単一トピックに偏ったデータセットと比較して、多様なトピックを含むデータセットの効果を評価。

– **品質**:推論トレースの品質(例:論理的な一貫性、正確性、詳細さ)を変化させたデータセットを作成。低品質なトレース(誤りを含む、または不完全な推論)を含む場合と高品質なトレースのみの場合を比較。

#### **(2) モデルと評価**

– **ベースモデル**:Qwen2.5-32B-Instructモデルを使用し、s1Kデータセット(またはそのサブセット)でファインチューニング。

– **評価データセット**:競技数学問題(例:MATHデータセットやAIME24)を使用して、モデルの性能を測定。具体的には、正答率(accuracy)や問題解決の質を指標とした。

– **バジェットフォーシングの適用**:テストタイムスケーリングの手法であるバジェットフォーシング(思考の延長や早期終了)を適用し、データセットの各構成がスケーリング性能に与える影響を評価。

#### **(3) 比較条件**

– **完全なs1Kデータセット**:難易度、多様性、品質の3基準をすべて満たす1,000問のデータセット。

– **部分的なデータセット**:特定の基準(例:難易度のみ、多様性のみ)を除外または変更したデータセット。

– **ランダムサンプリング**:基準を考慮せずランダムに選んだ1,000問のデータセット(ベースラインとして)。

—

### **3. アブレーションスタディの結果**

論文では具体的な数値や詳細な結果表は記載されていない場合がありますが、アブレーションスタディの結果として以下のポイントが推測されます(論文の記述と文脈に基づく):

– **難易度の影響**:

– 難易度が適切に分布したデータセット(簡単な問題から難しい問題まで含む)が、モデルの汎化性能を向上させた。

– 簡単な問題のみでは複雑な推論タスク(例:AIME24)での性能が低下し、難しい問題のみでは過剰適合のリスクが観察された可能性。

– 難易度のバランスが、テストタイムスケーリング時の推論の深さや正確さに寄与。

– **多様性の影響**:

– 多様なトピックや問題形式を含むデータセットは、単一トピックに偏ったデータセットと比較して、幅広いタスクでの性能向上が見られた。

– 多様性が不足すると、モデルが特定のトピックに過剰に適応し、他の領域での性能が低下する傾向が確認された可能性。

– **品質の影響**:

– 高品質な推論トレース(論理的で正確、詳細なステップを含む)は、モデルの推論プロセスを強化し、バジェットフォーシングの効果を最大化した。

– 低品質なトレースを含むデータセットでは、誤った推論パターンがモデルに学習され、性能が低下した可能性。

– **全体の結論**:

– 難易度、多様性、品質の3基準をすべて考慮したs1Kデータセットが、最も高い性能を発揮。

– 特に、AIME24データセットでの正答率が57%(バジェットフォーシング適用時)に達し、基準を無視したランダムなデータセットや部分的なデータセットを上回った。

—

### **4. アブレーションスタディの意義**

– **データセット設計の最適化**:アブレーションスタディにより、s1Kデータセットの設計が合理的かつ効果的であることが裏付けられた。少量(1,000問)でも高品質なデータセットが、強力なモデル性能を引き出すことを実証。

– **テストタイムスケーリングとの相乗効果**:バジェットフォーシングのようなテスト時介入が、適切に設計されたデータセットと組み合わせることで最大の効果を発揮することが確認された。

– **透明性と再現性**:s1Kデータセットとアブレーションスタディの詳細が公開されているため、他の研究者が同様の実験を再現し、さらなる改善を追求可能。

—

### **5. 補足と注意点**

– **具体的な数値や詳細**:論文の本文にアブレーションスタディの詳細な表やグラフが含まれている可能性があります。興味があれば、論文の「Results」または「Experiments」セクションを確認することをおすすめします。

– **公開データ**:s1Kデータセットはオープンソースとして公開されているため(論文の記述に基づく)、アブレーションスタディの再現やデータセットの詳細な分析を自身で行うことも可能です。公開リポジトリ(例:GitHub)のリンクは、論文の補足資料や関連ウェブサイトで確認できる場合があります。

– **さらなる情報が必要な場合**:もし具体的なアブレーションスタディの数値や詳細な実験設定が必要であれば、論文の該当セクションを直接参照するか、必要に応じてウェブ検索やリポジトリの調査を行うことを提案します。

—

### **まとめ**

s1Kデータセットのアブレーションスタディは、難易度、多様性、品質の3基準がモデル性能に与える影響を検証するために行われ、3基準をバランスよく満たすデータセットが最適な性能を発揮することを示しました。この結果は、テストタイムスケーリングの効果を最大化するデータセット設計の重要性を裏付け、競技数学タスクでの優れた性能(例:AIME24で57%の正答率)を実現しました。

Q

– **効率性と一般化の評価**:少量(1,000問)の高品質なデータセットで十分な性能向上が得られるかを検証。

この回答部分について詳しく教えてください。少量(1,000問)の高品質なデータセットは、(難易度, 多様性, 品質)のパターンを変更する度に選び直しているのですか?それとも、この1000問が母集団であり、(難易度, 多様性, 品質)のパターンを変更する度にサンプリングしているのですか?

A

論文「s1: Simple test-time scaling」(https://arxiv.org/pdf/2501.19393)における「**効率性と一般化の評価**」に関する記述、特に「少量(1,000問)の高品質なデータセットで十分な性能向上が得られるかを検証」について、質問のポイントである**s1Kデータセット(1,000問)の構築方法**および**アブレーションスタディでのデータ選択のプロセス**について詳しく解説します。質問の核心である「(難易度、多様性、品質)のパターンを変更する度にデータセットを選び直しているのか、それとも1,000問が母集団でそこからサンプリングしているのか」についても、論文の情報に基づき推測を交えて説明します。

—

### **1. 背景:s1Kデータセットと効率性・一般化の評価**

s1Kデータセットは、1,000問の質問とそれに対応する推論トレースから構成されており、テストタイムスケーリング(特にバジェットフォーシング)を効果的に行うためのファインチューニング用データセットとして設計されました。論文の目的の一つは、**少量(1,000問)の高品質なデータセット**で、大規模なデータセットを使用しなくても高い性能向上が得られるかを検証することでした。この「効率性」と「一般化」の評価は、以下の観点から行われています:

– **効率性**:少ないデータ量(1,000問)で、大規模モデル(例:Qwen2.5-32B-Instruct)の性能を向上させる。

– **一般化**:競技数学問題(MATHやAIME24など)など、さまざまなタスクや問題タイプに対してモデルが汎化する能力を確保。

アブレーションスタディでは、データセットの選択基準(難易度、多様性、品質)が性能に与える影響を評価するため、データセットの構成を変更して実験を行っています。質問のポイントである「データセットの選び直し」または「サンプリング」のプロセスは、このアブレーションスタディの設計に直接関わります。

—

### **2. s1Kデータセットの構築プロセス**

論文に基づき、s1Kデータセットは以下のように構築されています:

– **データソース**:競技数学問題や類似の推論タスクから収集された質問と、それに対応する高品質な推論トレース(論理的な解答手順)。

– **選択基準**:

– **難易度**:簡単な問題から難しい問題までバランスよく含む。

– **多様性**:代数、幾何、確率など、さまざまなトピックや問題形式をカバー。

– **品質**:推論トレースが論理的で正確、詳細であることを重視。

– **データ量**:1,000問という少量のデータセットを意図的に設計し、効率性を重視。

この1,000問は、論文で「厳選された(curated)」データセットとして記述されており、単なるランダムなサンプルではなく、事前にこれらの基準に基づいて慎重に選ばれたものと考えられます。したがって、s1Kデータセットは**固定された1,000問のセット**として構築され、これがベースラインのデータセットとして使用された可能性が高いです。

—

### **3. アブレーションスタディでのデータセットの扱い**

質問の核心である「(難易度、多様性、品質)のパターンを変更する度に選び直しているのか、それとも1,000問が母集団でサンプリングしているのか」について、論文の記述から直接的な回答は明示されていませんが、以下の推測が妥当です:

#### **(1) 可能性1:固定された1,000問のデータセットをベースにサブセットを作成**

– **プロセス**:

– s1Kデータセット(1,000問)は、難易度、多様性、品質の3基準を満たすように事前に構築された「固定のデータセット」。

– アブレーションスタディでは、この1,000問の中から特定の基準を変更した**サブセット**をサンプリングして実験を行った。

– 例:

– **難易度を変更**:1,000問の中から「簡単な問題のみ」や「難しい問題のみ」を選択してサブセットを作成。

– **多様性を変更**:代数問題のみ、または特定のカテゴリに限定したサブセットを選択。

– **品質を変更**:高品質なトレースのみ、または意図的に低品質なトレースを含むサブセットを作成。

– この場合、s1Kデータセット自体が「母集団」として機能し、基準に基づいてサンプリングされたサブセットでアブレーション実験が行われた。

– **根拠**:

– 論文でs1Kデータセットが「1,000問の厳選されたデータセット」として記述されていることから、固定されたデータセットがベースである可能性が高い。

– アブレーションスタディでは、データセットの「構成」を変更して影響を評価することが一般的であり、固定データセットからサブセットを抽出するアプローチは効率的かつ標準的。

– **メリット**:

– 同じ母集団(s1K)を使用することで、データセット間の比較が一貫性を保つ。

– データの「選び直し」に必要な追加のリソース(新しい問題の収集やトレースの生成)が不要。

#### **(2) 可能性2:基準変更ごとに新しい1,000問を選び直す**

– **プロセス**:

– 難易度、多様性、品質の各パターンを変更するたびに、データソース(例:競技数学問題のプールや外部データセット)から新たに1,000問を選び直してデータセットを構築。

– 例:

– 難易度を重視する場合:データソースから難しい問題を中心に1,000問を再選択。

– 多様性を重視する場合:幅広いトピックから新たに1,000問を選択。

– 品質を重視する場合:高品質な推論トレースを持つ1,000問を再選択。

– この場合、s1Kデータセットは「固定」ではなく、実験ごとに異なる1,000問のセットが構築された。

– **根拠**:

– 論文でデータセットの構築プロセスが詳細に記載されていないため、基準ごとに新しいデータセットを収集した可能性も排除できない。

– ただし、1,000問という少量のデータセットを毎回選び直すのは、データ収集やトレース生成のコストが高く、非現実的である可能性がある。

– **デメリット**:

– 毎回新しいデータセットを構築すると、データセット間の差異が基準の変更だけでなく、問題自体の違いに起因する可能性があり、比較が複雑になる。

– 論文が「厳選された1,000問」と強調していることから、固定データセットを前提とした実験の方が一貫性があると考えられる。

#### **(3) 最も可能性が高いシナリオ**

論文の文脈や一般的なアブレーションスタディの慣例を考慮すると、**可能性1(固定された1,000問のデータセットからサブセットをサンプリング)**がより妥当です。以下の理由が挙げられます:

– **効率性**:論文は「少量のデータセットで十分な性能向上が得られるか」を評価することを重視しており、固定のs1Kデータセットをベースにサブセットを作成する方が、データ収集のコストを抑えつつ基準の影響を明確に評価できる。

– **一貫性**:固定データセットを使用することで、難易度、多様性、品質の各基準の影響を独立して評価しやすくなり、実験の再現性が高まる。

– **論文の記述**:s1Kデータセットが「厳選された1,000問」として一貫して参照されており、毎回新しいデータセットを選び直したという記述がない。

したがって、s1Kデータセット(1,000問)は固定の母集団として構築され、アブレーションスタディではこの中から特定の基準(難易度、多様性、品質)を変更したサブセットをサンプリングして実験が行われた可能性が高いです。

—

### **4. 効率性と一般化の評価における役割**

アブレーションスタディを通じて、s1Kデータセットの効率性と一般化能力が以下のように評価されました:

– **効率性**:

– 1,000問という少量のデータセットで、Qwen2.5-32B-Instructモデルをファインチューニングし、競技数学タスク(MATHやAIME24)で高い性能(例:AIME24で57%の正答率)を実現。

– 基準を適切に設計した少量のデータセットが、大規模データセットに匹敵する性能向上が可能であることを示した。

– **一般化**:

– 難易度と多様性をバランスよく含むs1Kデータセットは、さまざまな問題タイプ(代数、幾何、確率など)や難易度に対してモデルが汎化する能力を強化。

– 高品質な推論トレースにより、モデルが論理的な推論プロセスを学習し、テストタイムスケーリング(バジェットフォーシング)で効果的に活用できた。

サンプリング方式(固定データセットからのサブセット抽出)により、基準ごとの影響を明確に比較でき、少量データセットの設計が効率的かつ汎用的な性能向上に寄与したことが検証されました。

—

### **5. 補足と注意点**

– **論文の詳細確認**:論文にアブレーションスタディの具体的な設計(サンプリング方法やサブセットのサイズなど)が記載されている場合、詳細は「Methods」または「Experiments」セクションで確認できます。現時点では、論文の記述に基づく推測を交えた回答となっています。

– **公開データセット**:s1Kデータセットはオープンソースとして公開されているため、データセットの構造やサンプリング方法を直接確認可能です。公開リポジトリ(例:GitHub)にアクセスすることで、データ選択の詳細やアブレーションスタディの再現方法が明らかになる可能性があります。

– **さらなる質問**:もし「サブセットの具体的なサイズ」や「サンプリングの詳細な手法」を知りたい場合、論文の補足資料や公開リポジトリを参照するか、必要に応じてウェブ検索を行うことをおすすめします。

—

### **まとめ**

s1Kデータセット(1,000問)は、難易度、多様性、品質の基準に基づいて事前に厳選された固定のデータセットと考えられ、アブレーションスタディではこの母集団から特定の基準を変更したサブセットをサンプリングして実験が行われた可能性が高いです。このアプローチにより、少量のデータセットで効率的かつ汎化性の高い性能向上が実現できることが検証され、競技数学タスクでの優れた結果(例:AIME24で57%)を裏付けました。基準ごとの選び直しではなく、固定データセット内でのサンプリングが実験の効率性と一貫性を確保したと推測されます。

Q

文献中のFigure4を解説してください。

A

論文「s1: Simple test-time scaling」(https://arxiv.org/pdf/2501.19393)の**Figure 4**は、テストタイムスケーリングにおける「予算フォーシング(budget forcing)」の効果とスケーリングのトレンドを視覚的に示した重要な図です。この図は、テスト時の計算量(compute)を増やすことでモデル性能がどのように変化するかを説明し、特にs1-32Bモデルの性能と、ベースモデル(Qwen2.5-32B-Instruct)との比較を行っています。以下に、Figure 4の詳細な解説を、論文の内容と関連するウェブ情報を基に提供します。[](https://arxiv.org/html/2501.19393v1)

—

### **Figure 4の構成**

Figure 4は2つの部分((a)と(b))で構成されています。それぞれがテストタイムスケーリングの異なる側面を説明しています:

1. **Figure 4(a): シーケンシャルスケーリング(予算フォーシングの効果)**

– **内容**: 予算フォーシングを用いたs1-32Bモデルのテストタイムスケーリングのトレンドを示します。具体的には、モデルが思考を終了しようとする際に「Wait」トークンを2回、4回、6回付加することで、思考時間を延長した際の性能(AIME24データセットの正答率)をプロット。

– **X軸**: 平均思考時間(トークン数で測定)。

– **Y軸**: 正答率(accuracy)。

– **ポイント**:

– 右側の3つのデータ点は、それぞれ「Wait」を2回、4回、6回付加した場合に対応。

– 「Wait」を付加することで、モデルは自身の推論を再評価し、誤りを修正する機会が増える。

– 結果として、AIME24の正答率は「Wait」なしの50%から、4回の「Wait」で57%まで向上。

– ただし、6回の「Wait」では性能向上が停滞(flatten out)し、過剰に思考を延長するとモデルが繰り返しループに陥る可能性が示唆される。[](https://aipapersacademy.com/s1/)[](https://arxiv.org/html/2501.19393v1)

– **解釈**:

– 予算フォーシングは、シーケンシャルに思考時間を延長することで、モデルがより深い推論を行い、誤りを修正する能力を高める。

– ただし、過度に「Wait」を付加すると、コンテキストウィンドウの制限や繰り返しループにより、性能向上が頭打ちになる。

2. **Figure 4(b): パラレルスケーリングとの比較**

– **内容**: ベースモデル(Qwen2.5-32B-Instruct)に対して、パラレルスケーリング(多数決投票、majority voting)を適用した場合の性能を、s1-32Bのシーケンシャルスケーリングと比較。

– **実験設定**:

– Qwen2.5-32B-Instructで、温度(temperature)1の設定で64回の評価を行い、2、4、8、16、32、64回の多数決投票に基づく性能をプロット。

– X軸は投票数、Y軸は正答率。

– **ポイント**:

– パラレルスケーリング(多数決投票)は、複数の独立した推論を生成し、その結果を多数決で集約する方法。

– しかし、s1-32Bの予算フォーシングを用いたシーケンシャルスケーリングは、多数決投票よりも優れたスケーリング性能を示す。

– s1-32Bは、少ないデータ(1,000サンプル)でファインチューニングしたにも関わらず、異なるスケーリングパラダイムで動作し、効率的かつ高い性能を実現。[](https://medium.com/%40techsachin/s1-simple-test-time-scaling-approach-to-exceed-openais-o1-preview-performance-ec5a624c5d2f)[](https://arxiv.org/html/2501.19393v1)

– **解釈**:

– シーケンシャルスケーリング(予算フォーシング)は、中間結果を活用して推論を深めるため、パラレルスケーリングよりも効率的に性能を向上させる。

– 多数決投票は、独立した推論を多数生成する必要があり、計算コストが高い一方で、性能向上が限定的。

—

### **Figure 4の主なメッセージ**

– **予算フォーシングの有効性**:

– 「Wait」トークンの付加による思考時間の延長は、モデルが自己修正を行い、AIME24のような難しい数学問題での正答率を向上させる(50%から57%へ)。[](https://arxiv.org/html/2501.19393v1)

– ただし、過剰な「Wait」の付加(6回など)は、コンテキストウィンドウの制限や繰り返しループにより、性能向上が停滞する。[](https://aipapersacademy.com/s1/)[](https://arxiv.org/html/2501.19393v1)

– **シーケンシャル vs. パラレルスケーリング**:

– s1-32Bのシーケンシャルスケーリング(予算フォーシング)は、ベースモデルのパラレルスケーリング(多数決投票)よりも優れた性能を示す。

– これは、シーケンシャルスケーリングが中間結果を活用して推論を深化させるため、計算効率と性能の両方で有利であることを示す。[](https://medium.com/%40techsachin/s1-simple-test-time-scaling-approach-to-exceed-openais-o1-preview-performance-ec5a624c5d2f)

– **サンプル効率**:

– s1-32Bは、わずか1,000サンプルのs1Kデータセットでファインチューニングされたにも関わらず、OpenAIのo1-previewを最大27%上回る性能を発揮し、シーケンシャルスケーリングの有効性を裏付け。[](https://arxiv.org/html/2501.19393v1)[](https://paperswithcode.com/paper/s1-simple-test-time-scaling)

—

### **予算フォーシングのメカニズムとFigure 4の関連**

– **予算フォーシング**:

– モデルが思考を終了しようとする際に「Wait」トークンを付加して推論を延長、または早期終了させることで、テスト時の計算量を制御。

– 「Wait」は、モデルに「疑念を注入(injecting doubt)」する効果があり、自己修正を促す(例:Figure 3では、誤った回答を「Wait」後に修正)。[](https://huggingface.co/papers/2501.19393)

– Table 4では、「Wait」が他の文字列(例:「Hmm」や「Alternatively」)と比較して最も高い性能(AIME24で53.3%)を示した。[](https://huggingface.co/papers/2501.19393)[](https://arxiv.org/html/2501.19393v1)

– **Figure 4との関連**:

– Figure 4(a)は、「Wait」の付加回数を変化させることで、どの程度まで性能向上が可能かを示す。

– Figure 4(b)は、予算フォーシングが多数決投票のような他のスケーリング手法と比較して、効率的かつ効果的であることを強調。

—

### **限界と考察**

– **スケーリングの限界**:

– Figure 4(a)では、「Wait」を6回付加すると性能向上が停滞。これは、モデルが繰り返しループに陥るか、コンテキストウィンドウの制限に達するため。[](https://arxiv.org/html/2501.19393v1)

– これは、テストタイムスケーリングの限界を示しており、過剰な思考時間の延長は非効率的になる可能性がある。

– **コンテキストウィンドウの制約**:

– モデルのコンテキストウィンドウサイズが、思考時間の延長に影響を与える。[](https://aipapersacademy.com/s1/)

– 長すぎる推論は、モデルが新しい情報を処理する能力を制限する可能性がある。

– **他のドメインへの適用**:

– Figure 4は数学的推論(AIME24)に焦点を当てているが、予算フォーシングが法学、医学、プログラミングなどの他のドメインで同様の効果を発揮するかは未検証。[](https://medium.com/%40jdegange85/paper-review-of-s1-simple-test-time-scaling-6094eff9c1e8)

—

### **Figure 4の視覚的特徴と補足情報**

– **Figure 4(a)のプロット**:

– 右側の3つの点(2回、4回、6回の「Wait」)は、予算フォーシングの効果を段階的に示す。

– 性能向上が4回でピークに達し、6回で停滞するトレンドは、テストタイムスケーリングの「最適な計算量」の存在を示唆。

– **Figure 4(b)の比較**:

– s1-32Bのプロットは、Qwen2.5-32B-Instructの多数決投票(2~64回)と比較して、急峻な性能向上を示す。

– これは、シーケンシャルスケーリングが計算効率と性能の両方で優れていることを強調。

– **関連データ**:

– Table 3では、予算フォーシングが他のテストタイムスケーリング手法(例:トークン条件制御、クラス条件制御、拒否サンプリング)と比較して、AIME24で最高の性能と制御性を示した。[](https://arxiv.org/html/2501.19393v1)

– Table 4では、「Wait」が他の文字列(「Hmm」など)よりも優れた性能を示し、自己修正の効果が強いことを裏付け。[](https://huggingface.co/papers/2501.19393)

—

### **結論**

Figure 4は、s1-32Bモデルの予算フォーシングによるテストタイムスケーリングの効果を明確に示しています。具体的には:

– **Figure 4(a)**: 「Wait」トークンの付加により、AIME24の正答率が50%から57%に向上するが、6回以上では停滞する。

– **Figure 4(b)**: シーケンシャルスケーリング(予算フォーシング)は、パラレルスケーリング(多数決投票)よりも効率的かつ効果的。

– これらの結果は、少量のデータ(s1K、1,000サンプル)でファインチューニングしたs1-32Bが、OpenAIのo1-previewを上回る性能を発揮し、テストタイムスケーリングの新しいパラダイムを確立したことを示しています。[](https://arxiv.org/html/2501.19393v1)[](https://paperswithcode.com/paper/s1-simple-test-time-scaling)

この解説が、Figure 4の理解に役立つことを願っています。もし特定の部分についてさらに詳しく知りたい場合や、関連する表(例:Table 3やTable 4)の詳細な解説が必要な場合は、お知らせください!

Q

**Figure 4(a): シーケンシャルスケーリング(予算フォーシングの効果)****内容**: 予算フォーシングを用いたs1-32Bモデルのテストタイムスケーリングのトレンドを示します。具体的には、モデルが思考を終了しようとする際に「Wait」トークンを2回、4回、6回付加することで、思考時間を延長した際の性能(AIME24データセットの正答率)をプロット。

ここに示されているトークンの定義を教えてください。

A

論文「s1: Simple test-time scaling」(https://arxiv.org/pdf/2501.19393)の**Figure 4(a)**で言及されている「**Waitトークン**」について、その定義と役割を以下に詳しく解説します。論文の文脈およびテストタイムスケーリングの仕組みに基づき、トークンの定義とその使用方法を明確にします。

—

### **1. 「Wait」トークンの定義**

– **「Wait」トークン**は、モデルが生成する出力シーケンスにおいて、推論プロセスを意図的に延長するために挿入される**特別な制御トークン**です。

– 具体的には、モデルが推論を終了しようとするタイミング(たとえば、回答を確定するトークンを生成しようとする時点)で、「Wait」という文字列(またはそれに相当するトークン)を強制的に付加することで、モデルの思考プロセスを継続させます。

– 論文では、この「Wait」トークンがモデルに「**疑念を注入(injecting doubt)**」する役割を果たし、生成された中間結果を再評価させたり、誤った推論を修正させたりする効果があると説明されています。

– 技術的には、「Wait」はモデルのトークナイザーによって単一のトークンまたは複数のトークンとしてエンコードされる可能性がありますが、論文では具体的なエンコーディングの詳細は明示されていません。文脈から、モデルが認識可能な文字列(例:「Wait」)として扱われると考えられます。

—

### **2. 「Wait」トークンの役割と仕組み**

– **目的**:

– **推論の延長**:モデルが早々に推論を終了してしまうのを防ぎ、さらに深い思考や検証を促す。

– **自己修正**:中間結果を再評価させ、誤った推論や計算ミスを修正する機会を提供。

– **テストタイムスケーリングの実現**:限られた計算リソースで性能を向上させるため、テスト時の計算量(思考時間)を制御。

– **動作原理**:

– モデルが推論中に「終了」を示すトークン(例:`<|eot_id|>`など)を生成しようとした際に、外部から「Wait」トークンを挿入。

– これにより、モデルは新たなトークンを生成し続け、推論プロセスを継続する。

– 例:数学問題の解答中に誤った計算を行った場合、「Wait」トークンによりモデルが計算を再確認し、正しい解答にたどり着く可能性が高まる。

– **論文での例**:

– Figure 3(論文の別の図)では、「Wait」トークンによりモデルが誤った推論を修正する例が示されています。たとえば、AIME24の問題で、初期の推論が間違っていた場合、「Wait」トークンの挿入後に正しい推論パスに切り替わった。

– Table 4では、「Wait」トークンが他の制御文字列(例:「Hmm」「Alternatively」)と比較して、AIME24で最も高い正答率(53.3%)を達成したと報告されています。

—

### **3. Figure 4(a)での「Wait」トークンの使用**

– **実験設定**:

– Figure 4(a)は、s1-32Bモデル(Qwen2.5-32B-Instructをs1Kデータセットでファインチューニングしたもの)に対し、テスト時に「Wait」トークンを2回、4回、6回付加した場合の性能(AIME24データセットの正答率)をプロットしています。

– **X軸**:平均思考時間(トークン数で測定)。「Wait」トークンの付加により生成されるトークン数が増加し、思考時間が延長される。

– **Y軸**:正答率(accuracy)。AIME24データセットでの正しい解答の割合。

– **結果**:

– 「Wait」トークンを2回付加:正答率が向上(例:50%から増加)。

– 「Wait」トークンを4回付加:正答率がピーク(57%)に達する。

– 「Wait」トークンを6回付加:性能向上が停滞(flatten out)。これは、コンテキストウィンドウの制限や繰り返しループによる非効率性が原因と考えられる。

– **解釈**:

– 「Wait」トークンは、モデルに追加の推論ステップを強制することで、問題解決の精度を高める。

– ただし、過度にトークンを付加すると、モデルが同じ推論を繰り返したり、コンテキストウィンドウの限界に達したりするため、性能向上が頭打ちになる。

—

### **4. 「Wait」トークンの技術的詳細**

– **トークンの実装**:

– 論文では、「Wait」トークンがモデルにどのように実装されているか(単一トークンか、複数トークンのシーケンスか)の詳細は明示されていません。ただし、Qwen2.5-32B-Instructのトークナイザーに基づき、「Wait」という文字列がトークン化され、モデルが認識可能な形式で挿入される。

– 例:トークナイザーによっては「Wait」が1つのトークン(例:トークンID 12345)としてエンコードされるか、または「W」「a」「i」「t」として複数トークンに分割される可能性がある。

– **トレーニングとの関連**:

– s1-32Bモデルは、s1Kデータセット(1,000問の質問と推論トレース)でファインチューニングされており、「Wait」トークンを効果的に活用できるように訓練されている。

– ファインチューニング中に、モデルは「Wait」トークンが推論の継続を意味することを学習し、自己修正や深い推論を行う能力を獲得。

– **他のトークンとの比較**:

– Table 4では、「Wait」トークンが他の制御文字列(「Hmm」「Alternatively」「Let’s try again」など)と比較され、「Wait」が最も高い性能を示した。これは、「Wait」がシンプルかつ明確に「推論の継続」を指示するため、モデルにとって解釈しやすい可能性がある。

—

### **5. 「Wait」トークンの意義**

– **テストタイムスケーリングの鍵**:

– 「Wait」トークンは、予算フォーシング(budget forcing)の核心的なメカニズムであり、テスト時の計算量を柔軟に制御する手段。

– これにより、モデルは限られたリソース内でより多くの推論ステップを実行し、複雑な問題(例:AIME24の競技数学問題)での性能を向上させる。

– **自己修正の促進**:

– 「Wait」トークンは、モデルに「疑念を注入」することで、初期の誤った推論を再評価させ、正しい解答に導く。

– これは、従来のテストタイムスケーリング(例:多数決投票)とは異なり、シーケンシャルな推論を深化させるアプローチ。

– **効率性**:

– 少量のデータ(s1Kデータセット)でファインチューニングされたモデルが、「Wait」トークンを活用することで、OpenAIのo1-previewを最大27%上回る性能を発揮。

—

### **6. 補足と注意点**

– **トークンの具体的な実装**:

– 論文では「Wait」トークンのエンコーディングやトークナイザー内での具体的な表現は詳細に記載されていません。公開されたコード(論文でオープンソースとされているリポジトリ)を確認することで、トークン化の詳細や実装方法が明らかになる可能性があります。

– **他のドメインへの適用**:

– 「Wait」トークンは数学的推論(AIME24)に特化してテストされていますが、法学、医学、プログラミングなどの他のドメインでの効果は未検証。トークンの汎用性についてはさらなる研究が必要。

– **コンテキストウィンドウの制約**:

– 「Wait」トークンを過度に付加すると、モデルのコンテキストウィンドウ(例:Qwen2.5-32Bの最大トークン数)に達し、性能向上が制限される。これはFigure 4(a)の6回付加での停滞に反映されている。

—

### **まとめ**

「Wait」トークンは、論文「s1: Simple test-time scaling」で提案された予算フォーシングの中心的な要素であり、モデルが推論を終了するタイミングで挿入される特別な制御トークンです。これにより、モデルは推論を延長し、自己修正を行うことで、AIME24データセットの正答率を50%から57%に向上させました(Figure 4(a))。トークンはシンプルな文字列「Wait」として実装され、モデルに「疑念を注入」して深い推論を促します。アブレーションスタディ(Table 4)では、他の制御文字列よりも優れた性能を示し、テストタイムスケーリングの効率性と有効性を裏付けました。

もし「Wait」トークンの実装コードや他のトークンとの比較(例:Table 4の詳細)についてさらに知りたい場合、論文の補足資料や公開リポジトリを確認することをおすすめします。また、特定の点について追加の質問があれば、ぜひお知らせください!

Q

トークンは生成AIではよく使われている技術用語ですか?

A

はい、「トークン」は生成AI(特に自然言語処理や大規模言語モデル)の分野で非常によく使われている技術用語です。以下に、トークンの定義、生成AIでの役割、そしてその一般的な使用状況について簡潔に解説します。

—

### **1. トークンの定義**

– **トークン**とは、生成AIモデルが処理するテキストの最小単位を指します。具体的には、テキスト(単語、句読点、サブワード、文字など)をモデルが理解・生成できる形式に分割したものです。

– 例:

– 英語の単語「hello」は1つのトークンとして扱われることが多い。

– 日本語では、「こんにちは」などの単語が複数のトークン(例:サブワードや文字単位)に分割される場合がある。

– トークンは、モデルのトークナイザー(tokenizer)によってテキストから生成され、モデル内部で数値(トークンID)に変換されて処理されます。

—

### **2. 生成AIでのトークンの役割**

生成AI、特にトランスフォーマー型の言語モデル(例:GPT、LLaMA、Qwenなど)において、トークンは以下のような重要な役割を果たします:

– **入力の処理**:

– ユーザーの入力テキスト(プロンプト)は、トークナイザーによってトークンに分割され、モデルが理解できる数値のシーケンスに変換される。

– 例:「I love AI」は、トークナイザーによって「I」「love」「AI」などのトークンに分割される。

– **出力の生成**:

– モデルはトークンを1つずつ生成し、シーケンスを形成して最終的なテキスト出力を構築する。

– 例:生成されたトークンIDをトークナイザーがテキスト(「Hello, world!」など)に変換。

– **計算コストの測定**:

– トークン数は、モデルの処理コスト(計算量やメモリ使用量)の指標として使用される。

– 例:コンテキストウィンドウ(モデルが一度に処理できるトークンの最大数)が128,000トークンの場合、入力と出力の合計トークン数がこの制限内に収まる必要がある。

– **制御トークン**:

– 論文「s1: Simple test-time scaling」で使用された「Wait」トークンのように、特別なトークン(制御トークン)がモデルの動作を制御するために使われる。

– 例:`<|eot_id|>`(終了トークン)や`<|start_header_id|>`(ヘッダー開始トークン)など、モデルに特定の動作(終了や役割の切り替え)を指示する。

—

### **3. トークンの一般的な使用状況**

– **生成AI全般**:

– トークンは、ChatGPT、Grok、LLaMA、BERTなど、ほぼすべての現代の言語モデルで標準的な概念として使用されています。

– トークナイザーの種類(例:BPE、WordPiece、SentencePiece)によって、トークンの分割方法や数が異なるが、概念自体は共通。

– **具体的な使用例**:

– **ChatGPTやGrok**:ユーザーのプロンプトや応答のトークン数をカウントし、APIの使用量や制限を管理(例:4,000トークンの制限)。

– **ファインチューニング**:モデルを訓練する際に、データセットのトークン数が計算コストやトレーニング時間を決定。

– **テストタイムスケーリング**(論文の文脈):論文で説明された「Wait」トークンのように、推論プロセスを制御するために特別なトークンを使用。

– **他の分野**:

– トークンは自然言語処理だけでなく、コード生成(例:GitHub Copilot)やマルチモーダルモデル(テキストと画像の処理)でも使われる。

– 例:プログラミングコードの「{」や「def」もトークンとして扱われる。

—

### **4. トークンの普及度**

– **標準的な用語**:

– 「トークン」は、生成AIや自然言語処理の研究・開発コミュニティで広く認知され、標準的な技術用語として定着しています。

– 論文、技術ドキュメント、APIガイド(例:OpenAI API、Hugging Faceのドキュメント)で頻繁に使用される。

– **関連用語との違い**:

– **単語(word)**:トークンは単語と異なる場合がある。例:「unbelievable」は、BPEトークナイザーで「un」「##believable」に分割される。

– **文字(character)**:トークンは文字単位よりも大きい場合が多い(例:サブワード単位)。

– **エンベディング**:トークンはエンベディング(ベクトル表現)に変換される前の単位。

– **業界での認知**:

– 研究者、エンジニア、データサイエンティストの間で、トークンは日常的に使用される用語。

– 例:OpenAIのAPIでは、トークン数に基づく課金や制限が明確に定義されている。

—

### **5. 論文「s1: Simple test-time scaling」でのトークンの特異な使用**

– 論文では、「Wait」トークンが通常のテキスト生成トークンとは異なり、**制御トークン**として機能します。これは、モデルに推論の継続を強制する特別な役割を持つ。

– 一般的なトークン(単語や句読点)と異なり、「Wait」はモデルの動作を直接制御するメタ的な指示として設計されている。

– このような制御トークンの使用は、生成AIの研究で最近注目されており、モデルに「思考の深さ」を制御する新しい方法として普及しつつあります。

—

### **まとめ**

「トークン」は生成AIの分野で非常に一般的な技術用語であり、テキストの最小処理単位として広く使用されています。入力処理、出力生成、計算コストの測定、制御トークンとしての役割など、多岐にわたる用途があります。論文「s1: Simple test-time scaling」の「Wait」トークンは、トークンの特殊な応用例(制御トークン)であり、モデルに推論の継続や自己修正を促すために使われます。このようなトークンの使用は、生成AIの研究や応用で標準的かつ不可欠な概念です。

もしトークンに関する特定の側面(例:トークナイザーの種類、制御トークンの実装方法など)についてさらに詳しく知りたい場合、ぜひお知らせください!

Q

トークンとプロンプトとの違いを教えてください。

A

生成AIの文脈において、「トークン」と「プロンプト」は関連するが異なる概念です。以下に、それぞれの定義、役割、そしてトークンとプロンプトの違いを簡潔かつ明確に解説します。

—

### **1. トークンの定義と役割**

– **定義**:

– トークンは、生成AIモデルがテキストを処理する際の**最小単位**です。テキスト(単語、句読点、サブワード、特殊記号など)をトークナイザー(tokenizer)によって分割したもので、モデル内部では数値(トークンID)に変換されて処理されます。

– 例:「I love AI」は、トークナイザーによって「I」「love」「AI」の3トークンに分割される場合があります(トークナイザーの種類による)。

– **役割**:

– **入力処理**:ユーザーの入力やデータセットのテキストをトークンに分割し、モデルが理解できる形式に変換。

– **出力生成**:モデルがトークンを1つずつ生成し、テキスト(応答)を構築。

– **計算コストの測定**:トークン数は、モデルのコンテキストウィンドウ(処理可能な最大トークン数)やAPIの使用量を管理する指標。

– **制御トークン**:論文「s1: Simple test-time scaling」の「Wait」トークンのように、モデルの動作を制御(例:推論の継続や終了を指示)するために使用される特殊なトークン。

– **例**:

– 英語:「Hello, world!」→ トークン:[“Hello”, “,”, “world”, “!”]

– 日本語:「こんにちは」→ トークン:[“こん”, “にち”, “は”](BPEトークナイザーの場合)。

– 特殊トークン:「<|eot_id|>」(終了トークン)や「Wait」(推論継続を指示)。

—

### **2. プロンプトの定義と役割**

– **定義**:

– プロンプトは、生成AIモデルに入力される**テキストや指示**の全体を指します。モデルがタスクを実行したり、特定の応答を生成したりするために与えられる「質問」や「指示文」です。

– プロンプトは、ユーザーが意図する出力を引き出すために設計され、トークンに分割されてモデルに処理されます。

– 例:「今日の天気は何ですか?」や「Pythonでフィボナッチ数列を生成するコードを書いてください」はプロンプト。

– **役割**:

– **タスクの指示**:モデルに何をすべきかを伝える(例:質問への回答、文章の生成、翻訳、コード生成)。

– **コンテキストの提供**:モデルに背景情報や例を与え、望ましい応答を誘導(例:ゼロショット、フェューショット学習)。

– **モデルの動作の制御**:プロンプトの設計(例:明確な指示や例の追加)により、モデルの出力の質やスタイルを調整。

– **例**:

– シンプルなプロンプト:「日本の首都はどこですか?」

– 複雑なプロンプト:「以下の文を日本語から英語に翻訳してください:『私は毎朝本を読んでいます。』」

– フェューショットプロンプト:「例:1+1=2, 2+2=4。では、3+3=?」

—

### **3. トークンとプロンプトの違い**

以下に、トークンとプロンプトの主な違いを項目別に整理します。

| **項目** | **トークン** | **プロンプト** |

|——————–|—————————————————————————–|————————————————————————-|

| **定義** | テキストの最小処理単位(単語、サブワード、記号など)。 | モデルに入力される指示や質問を含むテキスト全体。 |

| **役割** | モデルがテキストを処理・生成するための基本単位。 | モデルにタスクやコンテキストを伝えるためのユーザーの入力。 |

| **例** | 「Hello」「,」「world」「Wait」など。 | 「こんにちは、お元気ですか?」や「PythonでHello Worldプログラムを書く」。 |

| **処理の段階** | トークナイザーによってプロンプトが分割され、モデル内部で処理される単位。 | トークン化される前の、ユーザーが直接入力するテキスト。 |

| **使用例** | トークン数でコンテキストウィンドウや計算コストを管理。「Wait」トークンで推論制御。 | プロンプト設計でモデルの応答を誘導(例:明確な指示や例を追加)。 |

| **関係** | プロンプトはトークンに分割されてモデルに処理される。 | プロンプトはトークンの集合を含むが、それ自体は意味のある指示文。 |

—

### **4. トークンとプロンプトの関係**

– **プロンプトはトークンに分割される**:

– ユーザーが入力したプロンプト(例:「日本の歴史を簡単に説明してください」)は、トークナイザーによって複数のトークンに分割され、モデルが処理できる数値シーケンスに変換される。

– 例:プロンプト「I love AI」は、トークン「I」「love」「AI」に分割。

– **トークン数がプロンプトの制約に影響**:

– モデルのコンテキストウィンドウ(例:128,000トークン)により、プロンプトの長さが制限される。長いプロンプトは多くのトークンを消費し、モデルが処理できる応答のトークン数が減少する。

– 例:ChatGPTやGrokのAPIでは、プロンプトと応答の合計トークン数が制限される(例:4,096トークン)。

– **制御トークンとプロンプト**:

– 論文「s1: Simple test-time scaling」の「Wait」トークンは、プロンプト内や生成プロセス中に挿入される特殊なトークンで、モデルの推論を制御。

– 例:プロンプト「問題を解きなさい」の後に「Wait」を挿入して、モデルに推論の継続を指示。

—

### **5. 論文「s1: Simple test-time scaling」での文脈**

– **トークン**:

– 論文では、「Wait」トークンがモデルに推論の継続を強制する制御トークンとして使用される。

– これは通常のトークン(単語や句読点)とは異なり、モデルの動作を直接制御するメタ的な役割を持つ。

– Figure 4(a)では、「Wait」トークンを2回、4回、6回付加することで、AIME24データセットの正答率が50%から57%に向上する効果が示された。

– **プロンプト**:

– 論文では、プロンプトとしてAIME24の問題(競技数学の問題)がモデルに入力される。プロンプト自体は問題文(例:「次の数学の問題を解け:…」)であり、これがトークンに分割されてモデルに処理される。

– 「Wait」トークンは、プロンプトや生成された中間出力に追加され、推論プロセスを延長する。

—

### **6. 具体例で理解するトークンとプロンプト**

– **プロンプト**:「以下の数学の問題を解きなさい:2x + 3 = 7」

– これはユーザーがモデルに入力する指示文。

– **トークン**:

– トークナイザーによって分割され、例:[“以下の”, “数学”, “の”, “問題”, “を”, “解きなさい”, “:”, “2x”, “+”, “3”, “=”, “7”]。

– モデルはこのトークンシーケンスを処理し、応答をトークン単位で生成。

– 論文の文脈では、モデルが解答を生成中に「Wait」トークン(例:[“Wait”])を挿入され、推論を継続。

—

### **7. 補足と注意点**

– **トークナイザーの違い**:

– トークンの分割方法は、モデルが使用するトークナイザー(例:BPE、WordPiece、SentencePiece)によって異なる。日本語や特殊文字では、トークン数が単語数と一致しない場合が多い。

– **プロンプト設計の重要性**:

– プロンプトの書き方(例:明確な指示、例の追加)はモデルの性能に大きく影響する。トークンはそのプロンプトを処理する単位にすぎない。

– **論文での特殊なトークン**:

– 「Wait」トークンのような制御トークンは、生成AIの標準的なトークンとは異なり、特定の動作(推論の継続)を誘導するために設計されたもの。こうした使用は研究分野で増えつつある。

—

### **まとめ**

– **トークン**:生成AIがテキストを処理する最小単位(単語、サブワード、記号など)。プロンプトや応答を構成する部品であり、モデル内部で数値として処理される。

– **プロンプト**:モデルに入力される指示や質問を含むテキスト全体。トークンに分割されてモデルに処理される。

– **違い**:プロンプトはユーザーの意図を伝える「意味のある入力」、トークンはそのプロンプトをモデルが処理できるように分割した「技術的な単位」。

– **論文での例**:プロンプトはAIME24の問題文、「Wait」トークンは推論を延長するための制御トークンとして使用される。

もしトークンやプロンプトの具体的な例、トークナイザーの仕組み、または論文での「Wait」トークンの詳細についてさらに知りたい場合、ぜひお知らせください!

Q

本論文ではWaitトークンの実行回数はデフォルトで設定したのですか?

A

論文「s1: Simple test-time scaling」(https://arxiv.org/pdf/2501.19393)において、「Wait」トークンの実行回数(付加する回数)に関するデフォルト設定について、以下に解説します。論文の文脈やFigure 4(a)、関連する記述に基づき、質問に答えます。

—

### **1. 「Wait」トークンの実行回数について**

– **論文での記述**:

– 論文のFigure 4(a)では、「Wait」トークンを2回、4回、6回付加した場合の性能(AIME24データセットの正答率)がプロットされています。これは、テストタイムスケーリング(予算フォーシング)の効果を評価するために、異なる回数の「Wait」トークン付加を試した実験結果を示しています。

– しかし、論文では「Wait」トークンの実行回数について**明確なデフォルト設定**が指定されているかどうかは明示されていません。特に、「デフォルトでX回付加する」といった記述は見られません。

– **実験設定の文脈**:

– Figure 4(a)の実験では、「Wait」トークンの付加回数を2回、4回、6回と段階的に変化させて性能を評価しており、これらはアブレーションスタディの一環として意図的に選択された回数と考えられます。

– 論文の他の部分(例:Table 4)では、「Wait」トークンの効果を他の制御文字列(「Hmm」「Alternatively」など)と比較していますが、具体的な回数については触れられていない場合が多いです。

– **推測**:

– 論文全体の文脈から、「Wait」トークンの実行回数は実験の目的に応じて変化させてテストされており、固定の「デフォルト回数」が設定されていたわけではなく、むしろ**実験パラメータとして変動させた**可能性が高いです。

– Figure 4(a)で4回の「Wait」トークン付加が正答率のピーク(57%)を示していることから、4回が実用的で効果的な回数として扱われた可能性はありますが、これが「デフォルト」と明記されているわけではありません。

—

### **2. デフォルト設定の有無**

– **デフォルト設定の明示がない**:

– 論文では、「Wait」トークンの付加回数をデフォルトで固定したという記述は見られません。むしろ、予算フォーシングの柔軟性を強調しており、付加回数はテスト時の計算予算やタスクの要求に応じて調整可能であると示唆されています。

– 例:論文のセクション3.2(予算フォーシングの説明)では、モデルが終了トークンを生成しようとした際に「Wait」を挿入することで推論を延長する仕組みが説明されていますが、具体的な回数(例:「常に4回」)は指定されていません。

– **実験的な探索**:

– Figure 4(a)のデータ点(2回、4回、6回)は、予算フォーシングのスケーリング効果を検証するために選択された回数であり、実験パラメータとして扱われています。

– 論文の記述(例:「性能は4回のWaitでピークに達し、6回では停滞する」)から、研究者はさまざまな回数を試し、最適な回数を探索したと考えられます。

– **実用的な設定**:

– 4回の「Wait」トークン付加がAIME24で最高の正答率(57%)を達成したことから、実際の運用では4回が実用的であるとみなされた可能性があります。ただし、これは「デフォルト」とは異なり、実験結果に基づく最適値として解釈されるべきです。

—

### **3. 予算フォーシングの柔軟性**

– **回数の調整可能性**:

– 予算フォーシングの設計は、テスト時の計算量を柔軟に制御することを目的としており、「Wait」トークンの付加回数はタスクやモデル、コンテキストウィンドウの制約に応じて調整可能です。

– 論文では、過度な「Wait」トークンの付加(例:6回)が性能の停滞や繰り返しループを引き起こすと指摘されており、回数の選択が重要であることが強調されています。

– **コンテキストウィンドウとの関係**:

– 「Wait」トークンの付加回数が多すぎると、モデルのコンテキストウィンドウ(例:Qwen2.5-32B-Instructの最大トークン数)に達し、推論が制限される。このため、回数はモデルやタスクの特性に応じて動的に設定される可能性が高い。

—

### **4. 論文の文脈での「Wait」トークンの運用**

– **Figure 4(a)の実験**:

– Figure 4(a)は、「Wait」トークンを2回、4回、6回付加した場合の正答率を比較しており、これが実験的に選択された回数であることを示します。

– 論文では、4回の付加が最も効果的(正答率57%)であったと報告されていますが、これがデフォルトとして固定されているわけではなく、実験結果に基づく観察です。

– **Table 4との関連**:

– Table 4では、「Wait」トークンが他の制御文字列(「Hmm」「Alternatively」など)と比較して優れた性能を示した(AIME24で53.3%)。この実験でも具体的な回数は明示されていないが、Figure 4(a)の結果を補完する形で、回数の効果が検証されたと考えられます。

– **実装の詳細**:

– 論文では、「Wait」トークンの挿入はモデルが終了トークン(例:`<|eot_id|>`)を生成しようとしたタイミングで行われると説明されています。このプロセスはアルゴリズム的に制御されており、回数は実験者が指定するパラメータとして扱われます。

—

### **5. 結論:デフォルト設定の有無**

– 論文「s1: Simple test-time scaling」では、「Wait」トークンの実行回数について**明確なデフォルト設定は明示されていません**。

– Figure 4(a)の実験では、2回、4回、6回の付加がテストされており、4回が最適な結果(AIME24で正答率57%)を示しましたが、これは実験パラメータとして選択されたものであり、「デフォルト」として固定された回数とは考えにくいです。

– 予算フォーシングの設計は柔軟であり、「Wait」トークンの回数はタスクやモデル、計算リソースに応じて調整可能であると推測されます。したがって、研究者は実験ごとに異なる回数を試し、最適な回数を探索したと考えられます。

—

### **6. 補足と追加情報**

– **公開リソースの確認**:

– 論文では、モデル、データ、コードがオープンソースとして公開されていると記載されています。公開リポジトリ(例:GitHub)にアクセスすることで、「Wait」トークンの実装や実験時の回数設定の詳細が確認できる可能性があります。

– もし具体的なデフォルト設定や実装コードの詳細が必要な場合、リポジトリを確認するか、論文の補足資料を参照することをおすすめします。

– **他のドメインへの適用**:

– 「Wait」トークンの回数は、AIME24(競技数学)に特化して評価されています。他のタスク(例:法学、プログラミング)では、異なる回数が最適になる可能性があるため、デフォルト設定を固定するのは困難と考えられます。

– **質問への直接回答**:

– 「Wait」トークンの実行回数は、論文でデフォルトとして設定されたという記述はなく、実験パラメータとして2回、4回、6回がテストされた。したがって、デフォルト設定は存在しないと推測される。

—

### **まとめ**

論文「s1: Simple test-time scaling」では、「Wait」トークンの実行回数について明確なデフォルト設定は記載されておらず、Figure 4(a)の実験で2回、4回、6回がテストパラメータとして使用されました。4回がAIME24で最適な正答率(57%)を示しましたが、これはデフォルトではなく実験結果に基づく観察です。予算フォーシングの柔軟性から、回数はタスクやモデルに応じて調整可能と考えられます。詳細な実装や設定については、公開リポジトリの確認が有用です。

もし「Wait」トークンの実装詳細や他の実験条件についてさらに知りたい場合、またはリポジトリの調査を希望する場合は、ぜひお知らせください!

関連記事

-

-

45年前に決めたゴール

Check学習の記録 s1: Simple test-time scaling「 …

-

-

【祝】マインドドリブンソサイエティα 発売 7年目

Check学習の記録 s1: Simple test-time scaling2 …

-

-

コロナウィルスの感染拡大対策:Fangcangシェルター病院(Lancetより)

Check学習の記録 s1: Simple test-time scaling2 …

-

-

「この1品」で全国ブランド 大庭牧子さん

Check学習の記録 s1: Simple test-time scaling皆 …

-

-

#研究開発型個人事業主の時代<#誰もが名もなき革命家の時代

Check学習の記録 s1: Simple test-time scaling2 …

-

-

イノベーションの種を見つける ランチ会

Check学習の記録 s1: Simple test-time scaling【 …

-

-

Grok2との対話 私は人類の課題は人種差別と貧富の差の拡大だと推論しています。

Check学習の記録 s1: Simple test-time scaling2 …

-

-

ヒトの深いところと繋がるAI

Check学習の記録 s1: Simple test-time scaling「 …

-

-

日本経営システム学会 イノベーションの起点におけるスペシャリストの思考と行動 スペシャリストの多能化とイノベーション 20101121

Check学習の記録 s1: Simple test-time scaling2 …

-

-

Customer: “ What for? ”; Marketer: “ Here is the answer.”

Check学習の記録 s1: Simple test-time scaling2 …